大语言模型 (LLM) 的功能各不相同。为了让您在 AI 辅助软件开发方面拥有控制权和灵活性,Android Studio 可让您选择在个人机器上运行的本地模型来为 IDE 的 AI 功能提供支持。

选择模型

本地模型可替代 Android Studio 内置的 LLM 支持;不过,由于 Gemini 模型功能强大,Android Studio 中的 Gemini 通常可为 Android 开发者提供最佳 AI 体验。您可以为 Android 开发任务选择各种 Gemini 模型,包括免费的默认模型或通过付费 Gemini API 密钥访问的模型。

如果您需要离线工作、必须遵守有关 AI 工具使用的严格公司政策,或者有兴趣尝试使用开源研究模型,那么本地模型功能是一个不错的选择。

设置本地模型支持

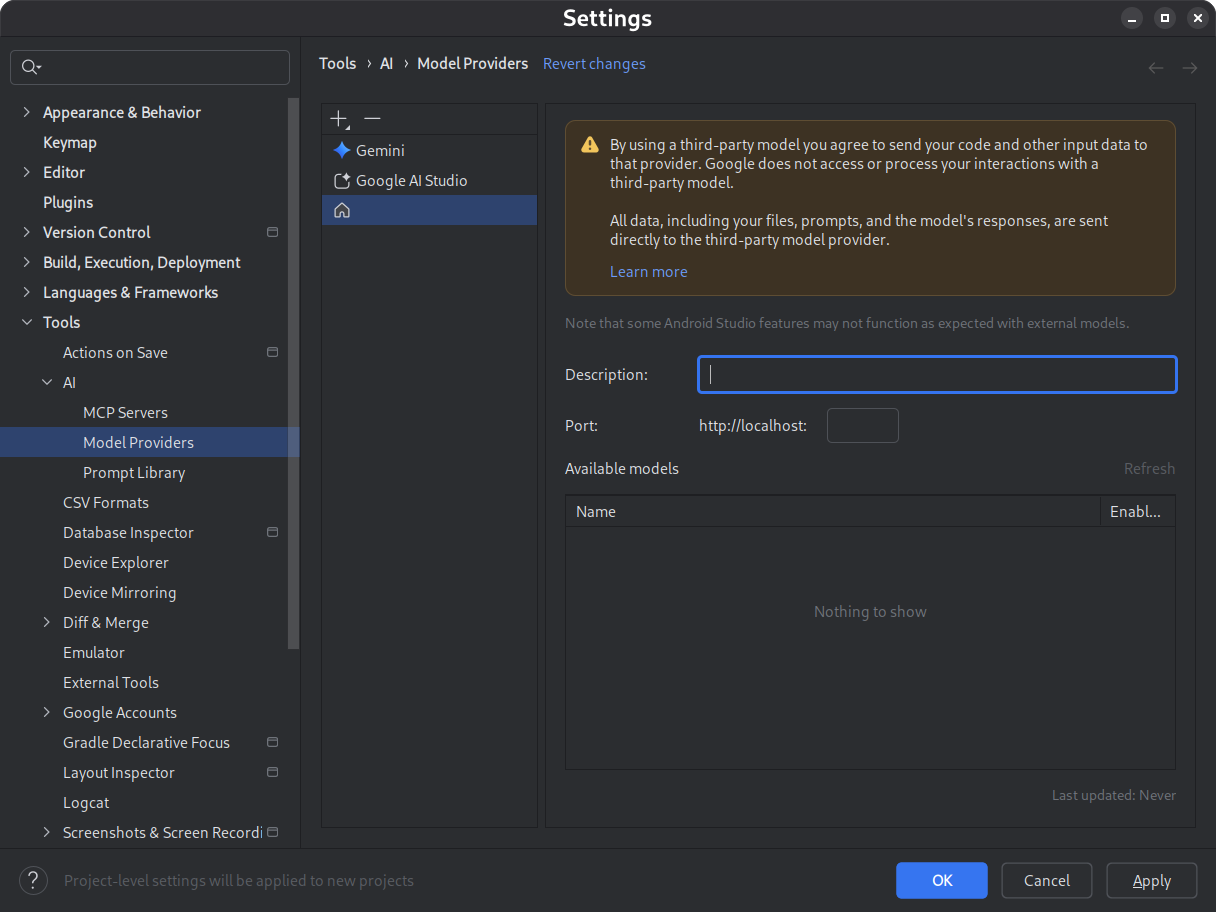

将模型提供程序添加到 Android Studio。

- 依次前往设置 > 工具 > AI > 模型提供商

- 选择 图标

- 选择本地提供商

- 输入模型提供商的说明(通常是模型提供商的名称)

- 设置提供程序监听的端口

- 启用模型

图 1. 模型提供方设置。 下载并安装您选择的型号。

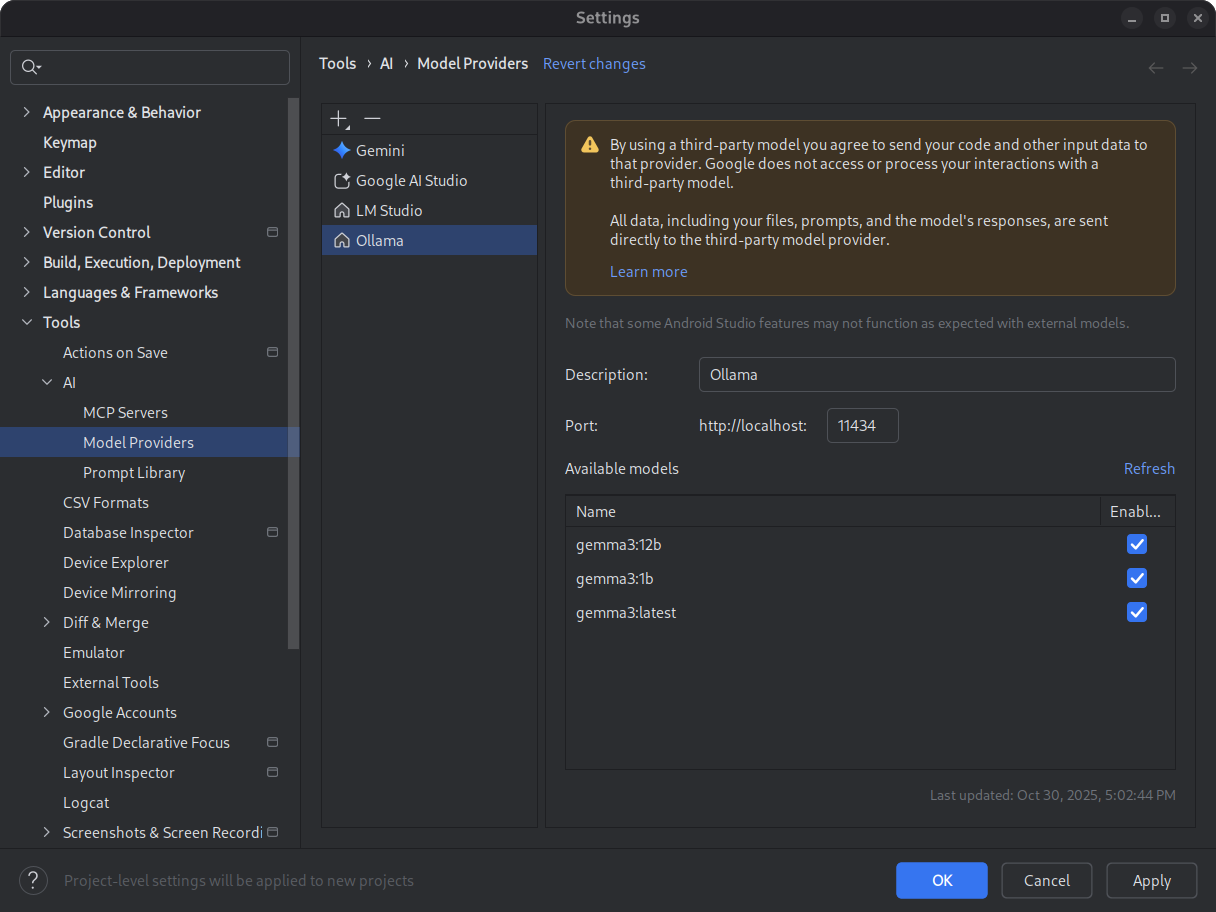

请参阅 LM Studio 和 Ollama 模型目录。为了在 Android Studio 中获得最佳代理模式体验,请选择经过工具使用训练的模型。

图 2. 可用的本地模型。 启动推理环境。

推理环境可将模型提供给本地应用。配置足够大的上下文长度令牌窗口,以获得最佳性能。 如需详细了解如何启动和配置环境,请参阅 Ollama 或 LM Studio 文档。

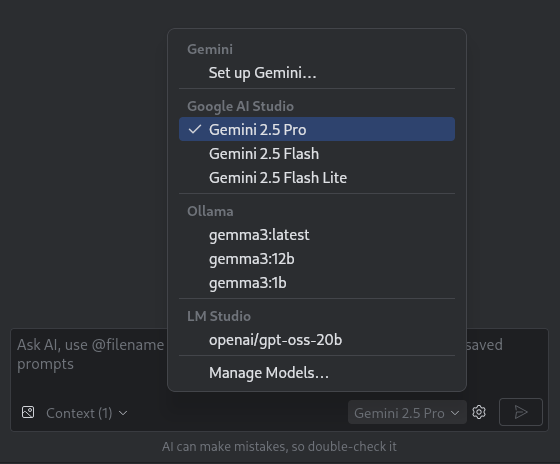

选择模型。

打开 Android Studio。前往 Gemini 对话窗口。使用模型选择器从默认 Gemini 模型切换到您配置的本地模型。

图 3. 模型选择器。

将 Android Studio 连接到本地模型后,您就可以使用 IDE 中的聊天功能了。所有互动完全由本地机器上运行的模型提供支持,为您提供一个自成一体的 AI 开发环境。

考虑性能限制

本地离线模型通常不如基于云端的 Gemini 模型高效或智能。与基于云端的模型相比,本地模型的聊天回答通常不太准确,延迟时间也更长。

本地模型通常不会针对 Android 开发进行微调,并且本地模型可能会返回与 Android Studio 界面无关的回答。某些 Android Studio AI 功能和 Android 开发用例无法通过本地模型正常运行。不过,Android Studio 中的 AI 聊天功能通常由本地模型提供支持。

如需快速获得有关 Android 开发各个方面的准确解答,并支持所有 Android Studio 功能,Android Studio 中的 Gemini(由 Gemini 模型提供支持)是您的最佳解决方案。